Сегодня Apple объявляет о трех новых усилиях по обеспечению защиты детей iPhone, iPad и Mac. Это включает в себя новые функции безопасности общения в сообщениях, улучшенное обнаружение материалов о сексуальном насилии над детьми (CSAM) в iCloud и обновленную информацию для Siri и поиска.

Apple подчеркивает, что ее новая программа амбициозна, но «защита детей — важная обязанность». Имея это в виду, Apple заявляет, что ее усилия будут «со временем развиваться и расширяться».

Сообщения

Первое объявление сегодня — это новая функция безопасности общения в приложении Сообщения. Apple объясняет, что когда ребенок из семьи iCloud получает или пытается отправить фотографии откровенно сексуального характера, ребенок увидит предупреждающее сообщение.

Apple объясняет, что когда ребенок получает изображение откровенно сексуального характера, изображение будет размытым, а приложение «Сообщения» отобразит предупреждение о том, что изображение «может быть чувствительным». Если ребенок нажмет «Посмотреть фото», он увидит всплывающее сообщение, информирующее его, почему изображение считается конфиденциальным.

Во всплывающем окне объясняется, что если ребенок решит просмотреть изображение, его родительский элемент iCloud Family получит уведомление, «чтобы убедиться, что вы в порядке». Во всплывающем окне также будет быстрая ссылка для получения дополнительной помощи.

Кроме того, если ребенок попытается отправить изображение сексуального характера, он увидит аналогичное предупреждение. Apple сообщает, что ребенок будет предупрежден перед отправкой фотографии, и родители могут получить сообщение, если ребенок решит отправить его, для детей младше 13 лет.

Apple также объясняет, что Messages использует машинное обучение на устройстве для анализа вложенных изображений и определения того, является ли фотография откровенно сексуальной. iMessage остается зашифрованным, и Apple не получает доступа ни к одному из сообщений. Эта функция также будет включена.

Apple заявляет, что эта функция появится «позже в этом году для учетных записей, созданных как семьи в iCloud» в обновлениях iOS 15, iPadOS 15 и macOS Monterey. Для начала функция будет доступна в США.

Обнаружение CSAM

Во-вторых, и это, возможно, наиболее примечательно, Apple объявляет о новых шагах по борьбе с распространением материалов о сексуальном насилии над детьми, или CSAM. Apple объясняет, что CSAM относится к контенту, изображающему откровенно сексуальные действия с участием ребенка.

Эта функция, которая частично просочилась ранее сегодня, позволит Apple обнаруживать известные изображения CSAM, когда они хранятся в iCloud Photos. Затем Apple может сообщать о случаях CSAM в Национальный центр пропавших без вести и эксплуатируемых детей, организацию, которая действует как комплексное агентство по отчетности для CSAM и тесно сотрудничает с правоохранительными органами.

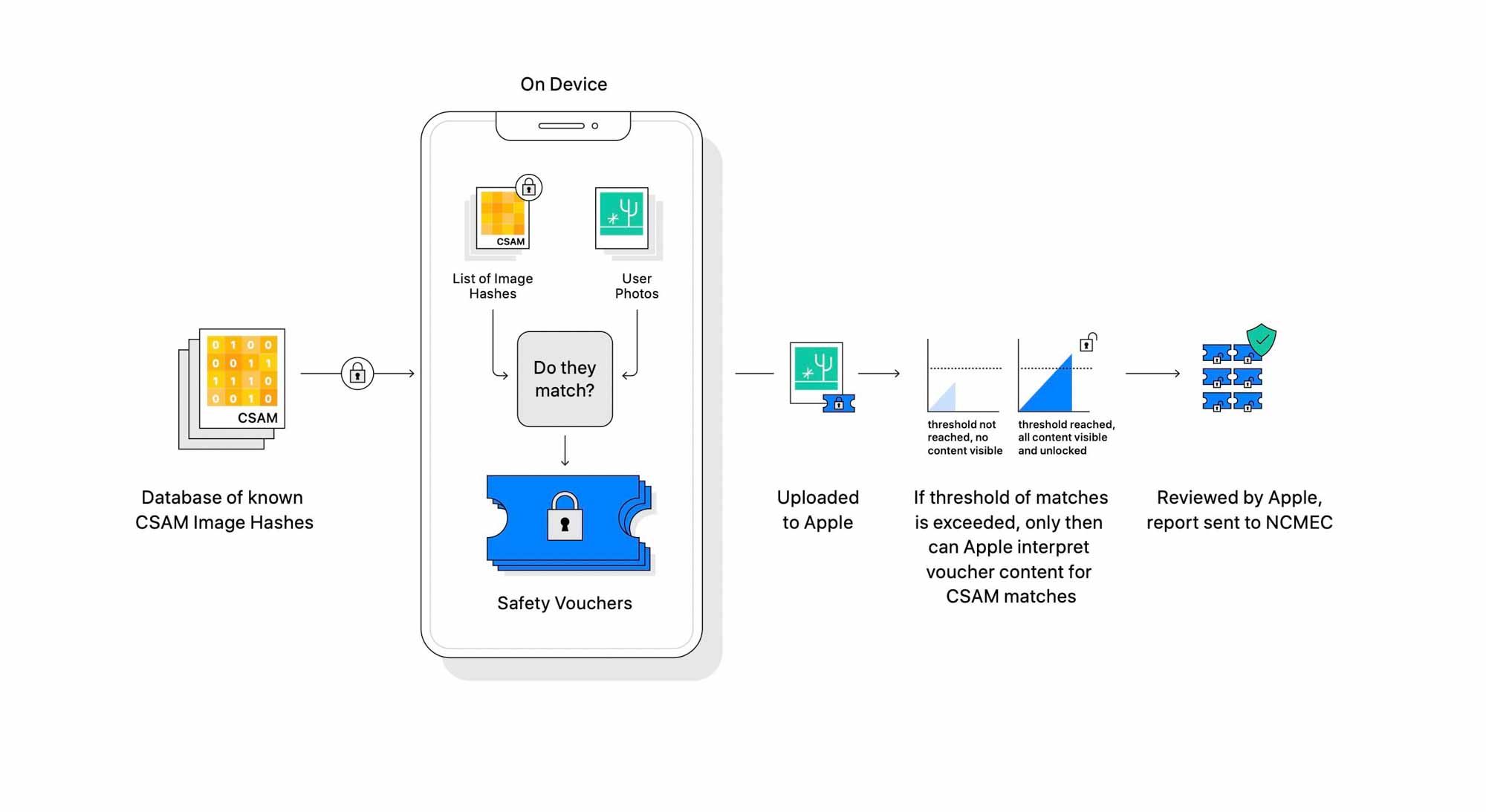

Apple неоднократно подчеркивает, что ее метод обнаружения CSAM разработан с учетом конфиденциальности пользователей. Говоря простым языком, Apple, по сути, анализирует изображения на вашем устройстве, чтобы увидеть, есть ли какие-либо совпадения с базой данных известных изображений CSAM, предоставленной Национальным центром пропавших без вести и эксплуатируемых детей. Все сопоставления выполняются на устройстве, при этом Apple преобразует базу данных Национального центра пропавших без вести и эксплуатируемых детей в «нечитаемый набор хэшей, который надежно хранится на устройствах пользователей».

Apple объясняет:

Прежде чем изображение будет сохранено в iCloud Photos, на устройстве выполняется процесс сопоставления этого изображения с нечитаемым набором известных хэшей CSAM. Этот процесс сопоставления основан на криптографической технологии, называемой пересечением частных наборов, которая определяет наличие совпадения без раскрытия результата. Пересечение частных наборов (PSI) позволяет Apple узнать, совпадает ли хэш изображения с известными хэшами изображений CSAM, не узнавая ничего о хэшах изображений, которые не совпадают. PSI также не позволяет пользователю узнать, было ли совпадение.

Если есть совпадение на устройстве, устройство затем создает ваучер криптографической безопасности, который кодирует результат совпадения. Затем используется технология, называемая пороговым разделением секрета. Это гарантирует, что содержимое ваучера безопасности не может быть интерпретировано Apple, если учетная запись iCloud Photos не превышает пороговое значение известного содержимого CSAM.

«Например, если секрет разделен на 1000 долей, а порог равен 10, то секрет может быть восстановлен из любых 10 долей из 1000. Однако, если доступно только девять акций, секрет ничего не разглашает », — заявляет Apple.

Apple не раскрывает конкретный порог, который она будет использовать, то есть количество совпадений CSAM, необходимых для того, чтобы она могла интерпретировать содержимое ваучеров безопасности. Однако как только этот порог будет достигнут, Apple вручную рассмотрит отчет, чтобы подтвердить совпадение, затем отключит учетную запись пользователя и отправит отчет в Национальный центр пропавших без вести и эксплуатируемых детей.

Пороговая технология важна, потому что она означает, что учетные записи не помечаются неправильно. Ручная проверка также добавляет еще один шаг подтверждения, чтобы предотвратить ошибки, и пользователи смогут подать апелляцию на восстановление своей учетной записи. Apple заявляет, что система имеет низкий уровень ошибок — менее 1 на 1 триллион счетов в год.

Несмотря на то, что все делается на устройстве, Apple анализирует только изображения, хранящиеся в iCloud Photos. Изображения, хранящиеся полностью локально, в этом процессе не участвуют. Apple заявляет, что система на устройстве важна и обеспечивает большую конфиденциальность, чем сканирование в облаке, потому что она сообщает только о пользователях, у которых есть изображения CSAM, в отличие от постоянного сканирования всех фотографий в облаке.

Реализация этой функции в Apple носит сугубо технический характер, и более подробную информацию можно узнать по ссылкам ниже.

Apple заявляет, что эта функция сначала появится в Соединенных Штатах, но в конечном итоге надеется расширить ее и в других странах.

Siri и поиск

Наконец, Apple обновляет Siri и Search:

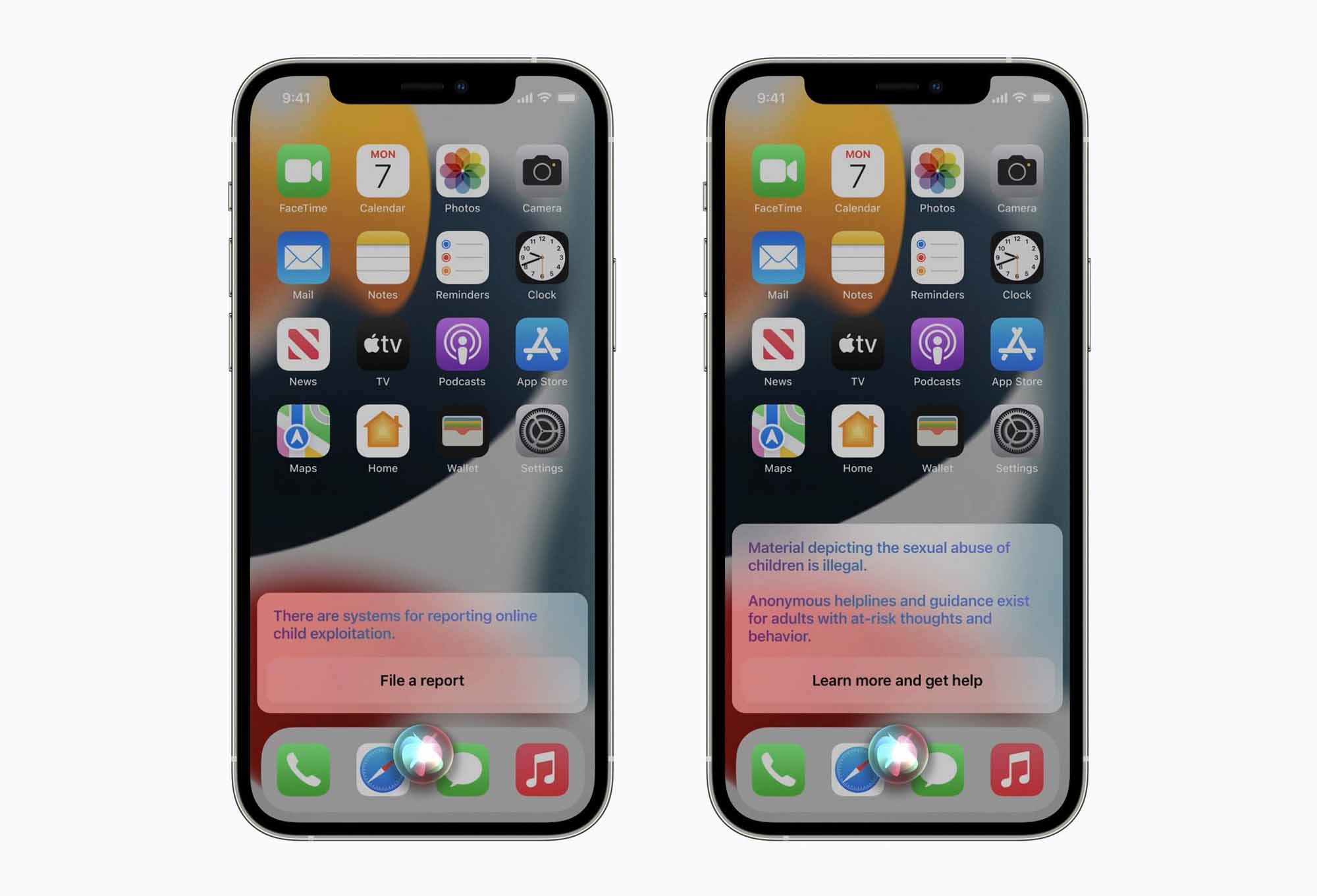

Apple также расширяет возможности Siri и Поиска, предоставляя дополнительные ресурсы, чтобы помочь детям и родителям оставаться в безопасности в Интернете и получать помощь в небезопасных ситуациях. Например, пользователям, которые спрашивают Siri, как они могут сообщить о CSAM или эксплуатации детей, будут указаны ресурсы, где и как отправить отчет.

Siri и Search также обновляются, чтобы вмешиваться, когда пользователи выполняют поиск запросов, связанных с CSAM. Эти вмешательства объяснят пользователям, что интерес к этой теме вреден и проблематичен, и предоставят ресурсы от партнеров для получения помощи в этом вопросе.

Обновления для Siri и Search появятся позже в этом году в обновлении iOS 15, iPadOS 15, watchOS 8 и macOS Monterey.

Отзывы

Джон Кларк, президент и главный исполнительный директор Национального центра пропавших без вести и эксплуатируемых детей: «Расширенная защита детей Apple меняет правила игры. Поскольку так много людей используют продукты Apple, эти новые меры безопасности могут спасти жизнь детям, которых заманивают в сети и чьи ужасающие изображения распространяются в материалах о сексуальном насилии над детьми. В Национальном центре по делам пропавших без вести и эксплуатируемых детей мы знаем, что с этим преступлением можно бороться только в том случае, если мы будем непоколебимы в нашей приверженности защите детей. Мы можем сделать это только потому, что технологические партнеры, такие как Apple, активизируются и заявляют о своей приверженности. Реальность такова, что конфиденциальность и защита детей могут сосуществовать. Мы аплодируем Apple и надеемся на совместную работу, чтобы сделать этот мир более безопасным для детей ».

Джули Кордуа, генеральный директор Thorn: «В Thorn мы верим в право на конфиденциальность в Интернете, в том числе в отношении детей, сексуальные домогательства которых регистрируются и распространяются в Интернете без согласия. Обязательство Apple по развертыванию технологических решений, которые уравновешивают потребность в конфиденциальности с цифровой безопасностью для детей, приближает нас на шаг ближе к правосудию в отношении выживших, чьи самые травматические моменты распространяются в Интернете; на шаг ближе к миру, где каждая цифровая платформа с кнопкой загрузки предназначена для упреждающего обнаружения CSAM во всех средах; и на шаг ближе к миру, где у каждого ребенка есть возможность быть просто ребенком ».

Стивен Балкам, основатель и генеральный директор Института семейной онлайн-безопасности: «Мы поддерживаем постоянное развитие подхода Apple к безопасности детей в Интернете. Учитывая проблемы, с которыми сталкиваются родители при защите своих детей в сети, крайне важно, чтобы технологические компании постоянно совершенствовали и совершенствовали свои инструменты безопасности, чтобы реагировать на новые риски и реальный вред ».

Бывший генеральный прокурор Эрик Холдер: «Исторический рост количества онлайн-материалов о сексуальном насилии над детьми — это проблема, которую необходимо решать с помощью инноваций со стороны технологов. Новые усилия Apple по обнаружению CSAM представляют собой важную веху, демонстрирующую, что безопасность детей не обязательно должна происходить за счет конфиденциальности, и являются еще одним примером давнего стремления Apple сделать мир лучше, последовательно защищая конфиденциальность потребителей ».

Бывший заместитель генерального прокурора Джордж Тервиллигер: «Заявления Apple представляют собой очень важный и долгожданный шаг как в расширении прав и возможностей родителей, так и в оказании помощи правоохранительным органам в их усилиях по предотвращению причинения вреда детям со стороны поставщиков CSAM. Благодаря расширенным усилиям Apple по обнаружению и сообщению CSAM правоохранительные органы смогут лучше выявлять и останавливать тех в нашем обществе, которые представляют наибольшую угрозу для наших детей ».

Бенни Пинкас, профессор факультета компьютерных наук Университета Бар-Илан: «Система Apple PSI обеспечивает отличный баланс между конфиденциальностью и полезностью и будет чрезвычайно полезна для идентификации содержимого CSAM при сохранении высокого уровня конфиденциальности пользователей и сохранении ложных срабатываний. до минимума ».

Михир Белларе, профессор факультета компьютерных наук и инженерии Калифорнийского университета в Сан-Диего: «Принятие мер по ограничению CSAM — это похвальный шаг. Но его реализация требует некоторой осторожности. Наивно сделанный, он требует сканирования фотографий всех пользователей iCloud. Но наши фотографии — это личные фотографии, на которых запечатлены события, моменты и люди из нашей жизни. Пользователи ожидают и желают, чтобы они оставались конфиденциальными от Apple. В свою очередь, база данных фотографий CSAM не должна публиковаться или становиться известной пользователю. Apple нашла способ выявлять нарушителей CSAM и сообщать о них при соблюдении этих ограничений конфиденциальности ».

Дэвид Форсайт, заведующий кафедрой компьютерных наук Университета Иллинойса инженерного колледжа Урбана-Шампань: «Подход Apple сохраняет конфиденциальность лучше, чем любой другой, о котором я знаю. […] По моему мнению, эта система, вероятно, значительно увеличит вероятность того, что люди, которые владеют или продают [CSAM] найдены; это должно помочь защитить детей. Безобидные пользователи должны испытывать минимальную потерю конфиденциальности или ее отсутствие, потому что визуальные производные обнаруживаются только в том случае, если имеется достаточное количество совпадений с изображениями CSAM, и только для изображений, которые соответствуют известным изображениям CSAM. Точность системы сопоставления в сочетании с пороговым значением делает очень маловероятным обнаружение изображений, которые не являются известными изображениями CSAM ».