iMessage может предупреждать несовершеннолетних о наготе на фотографиях

Apple и Microsoft предоставили подробную информацию о своих методах обнаружения или предотвращения распространения материалов о сексуальном насилии над детьми, и австралийский регулирующий орган обнаружил, что их усилия недостаточны.

Австралийский комиссар по электронной безопасности потребовал, чтобы крупные технологические фирмы, такие как Apple, Facebook, Snapchat, Microsoft и другие, подробно описали свои методы предотвращения жестокого обращения с детьми и их эксплуатации на своих платформах. Требование было предъявлено 30 августа, и у компаний было 29 дней, чтобы выполнить его, иначе им грозят штрафы.

Apple и Microsoft — первые компании, прошедшие проверку в рамках этого обзора, и, по данным Reuters, австралийский регулятор счел их усилия недостаточными. Обе компании не проводят упреждающее сканирование пользовательских файлов в iCloud или OneDrive на наличие CSAM, а также не используют алгоритмические алгоритмы обнаружения для FaceTime или Skype.

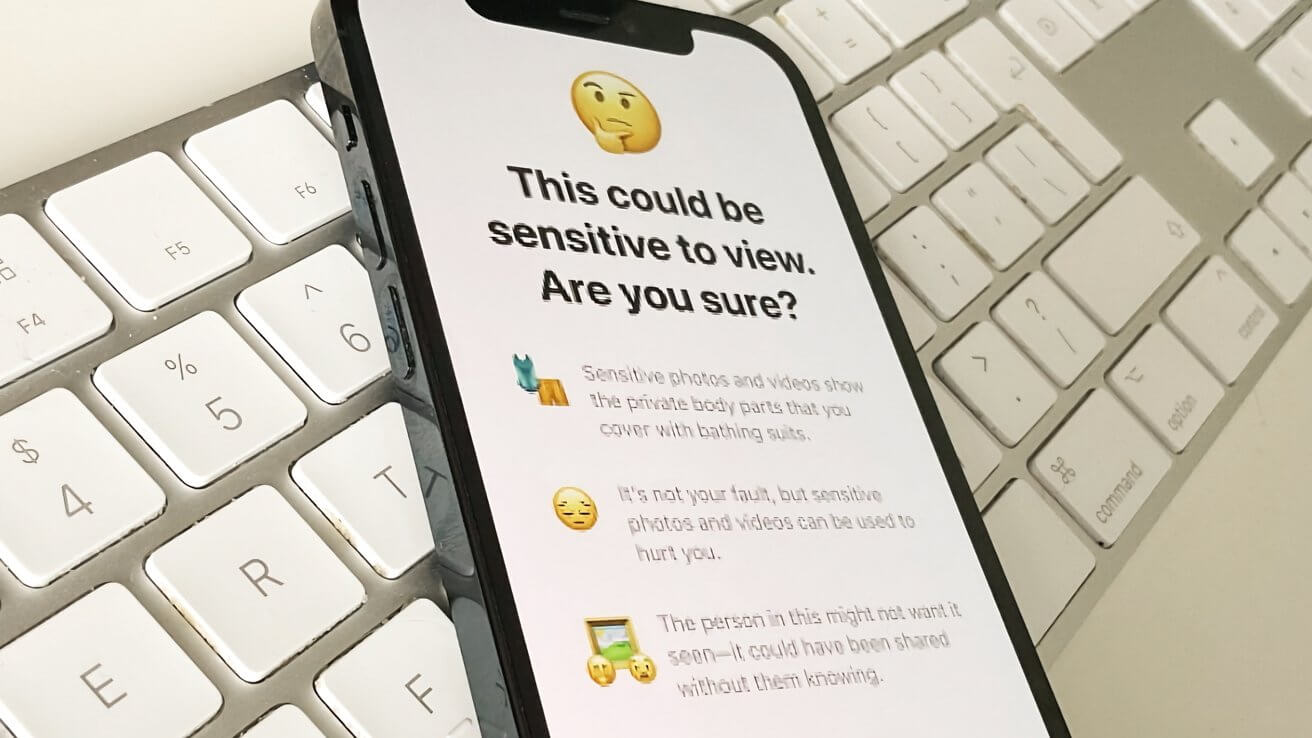

Вместо сканирования существующего контента, хранящегося или распространяемого, Apple решила использовать другой подход, который со временем будет развиваться. В настоящее время устройства, используемые детьми, могут быть настроены родителями для предупреждения ребенка, если на фотографиях, отправляемых через iMessage, обнаруживается нагота.

Apple планирует расширить эту возможность для обнаружения материала в видео, а затем перенести систему обнаружения и предупреждения в FaceTime и другие приложения Apple. Со временем компания надеется создать API, который позволит разработчикам использовать систему обнаружения в своих приложениях.

Сторонники конфиденциальности приветствовали отказ от обнаружения CSAM в iCloud. В то же время он был осужден группами безопасности детей, правоохранительными органами и государственными чиновниками.