Apple выпускает на своих платформах набор функций, направленных на защиту детей в Интернете, включая систему, которая может обнаруживать материалы о жестоком обращении с детьми в iCloud, сохраняя при этом конфиденциальность пользователей.

В четверг технический гигант Купертино объявил о новых функциях безопасности детей в трех областях, которые, по его словам, помогут защитить детей от хищников и ограничат распространение материалов о сексуальном насилии над детьми (CSAM). Официальное объявление следует за сообщениями о том, что Apple представит на своих платформах некий тип системы для ограничения CSAM.

«В Apple наша цель — создать технологию, которая расширяет возможности людей и обогащает их жизнь, помогая им оставаться в безопасности», — написала компания в пресс-релизе.

Например, Apple внедрит в «Сообщения» новые инструменты, которые позволят родителям быть более информированными о том, как их дети общаются в Интернете. Компания также использует новую систему, которая использует криптографические методы для обнаружения коллекций CSAM, хранящихся в iCloud Photos, для предоставления информации правоохранительным органам. Apple также работает над новыми инструментами безопасности в Siri и Search.

«Расширенная защита детей Apple меняет правила игры», — сказал Джон Кларк, генеральный директор и президент Национального центра пропавших без вести и эксплуатируемых детей.

Поскольку так много людей используют продукты Apple, эти новые меры безопасности могут спасти жизнь детям, которых заманивают в сети и чьи ужасающие изображения распространяются в материалах о сексуальном насилии над детьми. В Национальном центре по делам пропавших без вести и эксплуатируемых детей мы знаем, что с этим преступлением можно бороться только в том случае, если мы будем непоколебимы в нашей приверженности защите детей. Мы можем сделать это только потому, что технологические партнеры, такие как Apple, активизируются и заявляют о своей приверженности. Реальность такова, что конфиденциальность и защита детей могут сосуществовать. Мы аплодируем Apple и надеемся на совместную работу, чтобы сделать этот мир более безопасным для детей.

Все три функции также оптимизированы для обеспечения конфиденциальности, что гарантирует, что Apple может предоставлять информацию о преступной деятельности соответствующим органам, не угрожая частной информации законопослушных пользователей.

Обнаружение CSAM в Фото iCloud

Схема системы сканирования CSAM. Источник: Apple

Самая важная новая функция безопасности детей, которую Apple планирует дебютировать, сосредоточена на обнаружении CSAM в учетных записях iCloud Photos.

Если Apple обнаружит коллекции CSAM, хранящиеся в iCloud, она пометит эту учетную запись и предоставит информацию в NCMEC, который работает как центр отчетности для материалов о жестоком обращении с детьми и работает с правоохранительными органами по всей территории США.

Apple на самом деле здесь не сканирует изображения. Вместо этого он использует интеллектуальные возможности устройства для сопоставления CSAM с известной базой данных хэшей, предоставленной NCMEC и другими организациями, занимающимися безопасностью детей. Эта база данных преобразуется в нечитаемый набор хэшей, которые надежно хранятся на устройстве пользователя.

Фактический метод обнаружения CSAM в фотографиях iCloud сложен и использует криптографические методы на каждом этапе для обеспечения точности при сохранении конфиденциальности для среднего пользователя.

Apple заявляет, что помеченная учетная запись будет отключена после ручной проверки, чтобы убедиться, что это действительно положительный результат. После отключения учетной записи компания из Купертино отправит сообщение в NCMEC. У пользователей будет возможность подать апелляцию на прекращение действия учетной записи, если они почувствуют, что они были ошибочно выбраны.

Компания снова повторяет, что эта функция обнаруживает только CSAM, хранящиеся в iCloud Photos — она не будет применяться к фотографиям, хранящимся строго на устройстве. Кроме того, Apple утверждает, что в системе процент ошибок составляет менее одного на один триллион учетных записей в год.

Вместо облачного сканирования эта функция также сообщает только о пользователях, у которых есть набор известных CSAM, хранящихся в iCloud. Одного оскорбительного материала недостаточно, чтобы вызвать его, что помогает сократить количество ложных срабатываний.

Опять же, Apple заявляет, что узнает только об изображениях, соответствующих известному CSAM. Он не сканирует все изображения, хранящиеся в iCloud, и не будет получать или просматривать изображения, которые не соответствуют известному CSAM.

Система обнаружения CSAM будет применяться только к учетным записям iCloud в США. Apple заявляет, что, вероятно, в будущем развернет систему в более широком масштабе.

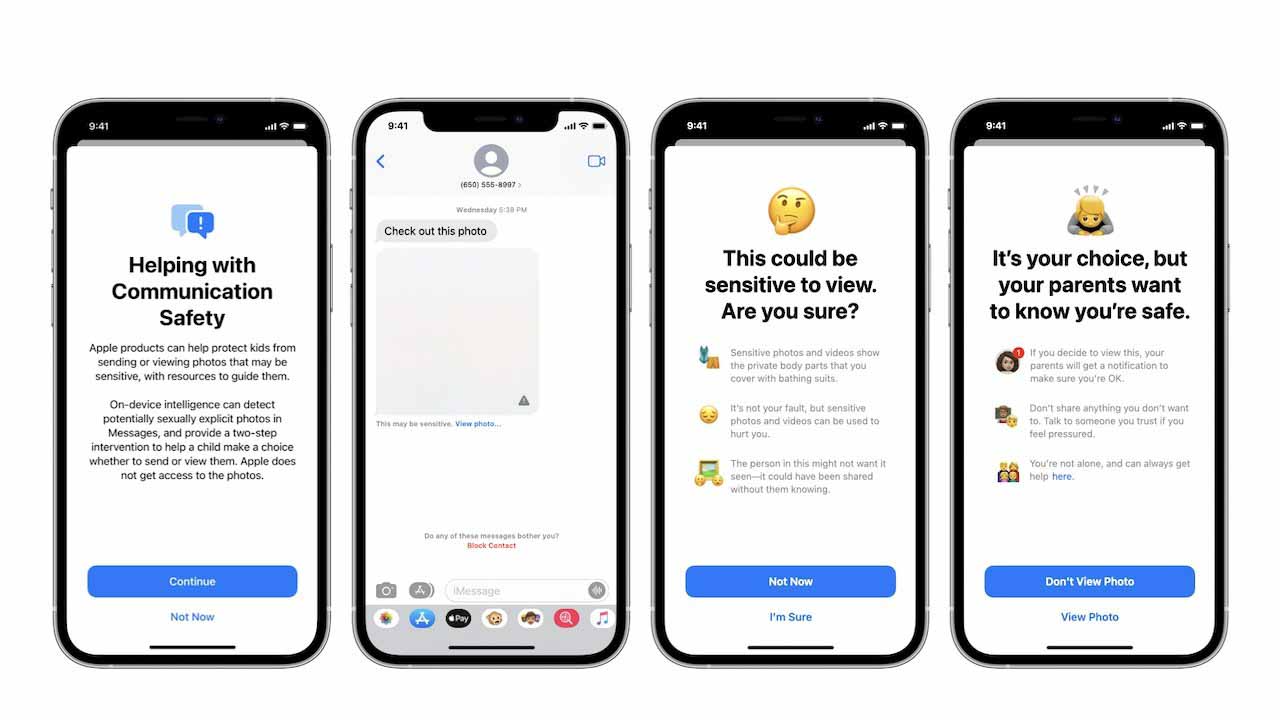

Безопасность общения

Одно из новых обновлений направлено на повышение безопасности общения детей в Интернете с помощью iMessage от Apple.

Например, приложение iMessage теперь будет показывать предупреждения детям и родителям, когда они получают или отправляют фотографии откровенно сексуального характера.

Если ребенок получает чувствительное изображение, оно будет автоматически размыто, и ребенку будут представлены полезные ресурсы. Apple также включила механизм, который позволит детям узнать, что сообщение будет отправлено их родителям, если они его просмотрят.

Система использует машинное обучение на устройстве для анализа изображений и определения их сексуального характера. Он специально разработан таким образом, чтобы Apple не получала и не получала копию изображения.

Обновления Siri и поиска

В дополнение к функциям безопасности iMessage Apple также расширяет инструменты и ресурсы, которые она предлагает в Siri и Search, когда речь идет о безопасности детей в Интернете.

Например, пользователи iPhone и iPad смогут спросить Siri, как они могут сообщить, что CSAM или ребенок может быть использован. Затем Siri предоставит необходимые ресурсы и рекомендации.

Siri и Search также обновляются, чтобы вмешиваться, если пользователи выполняют поиск или запросы для CSAM. Как отмечает Apple, «эти вмешательства объяснят пользователям, что интерес к этой теме вреден и проблематичен, и предоставят ресурсы от партнеров для получения помощи в решении этой проблемы».

Сохранение конфиденциальности пользователей

Apple давно заявляла, что делает все возможное для защиты конфиденциальности пользователей. Компания даже пошла плечом к плечу с правоохранительными органами по поводу прав пользователей на конфиденциальность. Вот почему введение системы, предназначенной для предоставления информации правоохранительным органам, обеспокоило некоторых экспертов по безопасности.

Такой инструмент может оказаться полезным для поиска детской порнографии в телефонах людей. Но представьте, что он может сделать в руках авторитарного правительства? https://t.co/nB8S6hmLE3

— Мэтью Грин (@matthew_d_green) 5 августа 2021 г.

Однако Apple утверждает, что слежка за системами и злоупотребление ими были «первоочередной задачей» при их разработке. В нем говорится, что каждая функция разработана таким образом, чтобы обеспечить сохранение конфиденциальности при противодействии CSAM или эксплуатации детей в Интернете.

Например, система обнаружения CSAM была разработана с самого начала для обнаружения только CSAM — она не содержит механизмов для анализа или обнаружения любых других типов фотографий. Более того, он обнаруживает только собрания CSAM, превышающие определенный порог.

Apple заявляет, что система не открывает двери для наблюдения и не делает ничего, чтобы ослабить шифрование. Система обнаружения CSAM, например, анализирует только фотографии, которые не имеют сквозного шифрования.

Эксперты по безопасности по-прежнему обеспокоены последствиями. Мэтью Грин, профессор криптографии в Университете Джона Хопкинса, отмечает, что хэши основаны на базе данных, которую пользователи не могут просмотреть. Более того, существует вероятность злоупотребления хешами — например, безобидное изображение, совместно используемое хешем с известным CSAM.

«Идея о том, что Apple — компания, обеспечивающая« конфиденциальность », купила им много хорошей прессы. Но важно помнить, что это та же компания, которая не будет шифровать ваши резервные копии iCloud, потому что на них оказывает давление ФБР», — написал Грин. .