Выступая на конференции Sight Tech Global в четверг, руководители Apple Крис Флейзак и Сара Херрлингер подробно остановились на усилиях компании по обеспечению доступности своих продуктов для пользователей с ограниченными возможностями.

В виртуальном интервью, проведенном Мэтью Панзарино из TechCrunch, Флейзак и Херрлингер подробно рассказали об истоках доступности в Apple, где она сейчас находится и что пользователи могут ожидать в будущем.

Флейзак, который возглавляет Apple по разработке специальных возможностей для iOS, рассказал о том, как специальные возможности появились на мобильной платформе компании. Возвращаясь к оригинальному iPhone, в котором отсутствовали многие функции доступности, на которые пользователи привыкли полагаться, он сказал, что команде Mac VoiceOver был предоставлен доступ к продукту только после того, как он был отправлен.

«И мы увидели, как вышло устройство, и начали думать, что, вероятно, сможем сделать его доступным», — сказал Флейзак. «Нам посчастливилось участвовать очень рано — я имею в виду, что проект был очень секретным, пока не был отправлен — очень скоро, сразу после того, как он был отправлен, мы смогли принять участие и начать создавать прототипы».

На создание iOS 3 в 2009 году ушло около трех лет.

Флейзак также предполагает, что проект VoiceOver для iPhone набрал обороты после случайной встречи с покойным соучредителем Стивом Джобсом. По его словам, Флейзач обедал (предположительно в кампусе Apple) с другом, который использует VoiceOver для Mac, а Джобс сидел рядом. Джобс подошел, чтобы обсудить технологию, и тогда друг Флейзаха спросил, может ли она быть доступна на iPhone. «Возможно, мы сможем это сделать», — сказал Джобс, по словам Флейзаха.

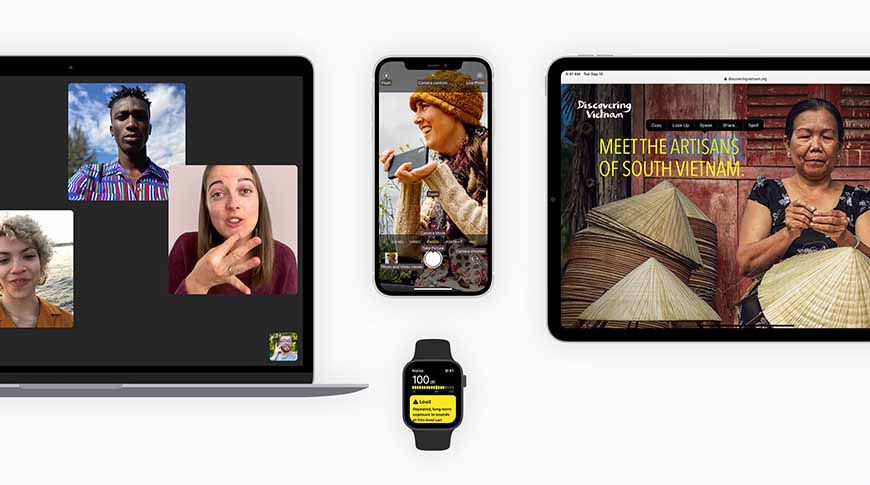

Изначально доступность в iOS превратилась в набор функций, который включает такие технологии, как Assistive Touch, приспособление для слуха, выбор звука, диктовку, распознавание звука и многое другое. Последний iPhone 12 Pro добавляет LiDAR в систему обнаружения людей.

Херрлингер, старший директор Apple по глобальной политике и инициативам в области доступности, говорит, что теперь команда по обеспечению доступности задействована на ранних этапах реализации различных проектов.

«На самом деле нас действительно очень рано привлекают к этим проектам», — сказала она. «Я думаю, что пока другие команды думают о своих примерах использования, возможно, для более широкой публики, они рассказывают нам о типах вещей, которые они делают, чтобы мы могли начать представлять, что мы могли бы с ними делать. перспектива доступности «.

Последние функции, такие как VoiceOver Recognition и Screen Recognition, основаны на передовых инновациях, связанных с машинным обучением. Последние устройства iOS включают чипы A-серии с Neural Engine от Apple, специализированным модулем нейронной сети, разработанным специально для вычислений машинного обучения.

VoiceOver Recognition — это пример новой функциональности на основе машинного обучения. С помощью этого инструмента iOS может не только описывать отображаемый на экране контент, но и делать это в контексте. Например, вместо того, чтобы сказать, что сцена включает в себя «собаку, бассейн и мяч», VoiceOver Recognition может интеллектуально преобразовать эти объекты в «собаку, перепрыгивающую через лужу, чтобы принести мяч».

Apple только поверхностно занимается машинным обучением. Как отмечает Панзарино, недавно опубликованное видео демонстрирует программное обеспечение, которое, по-видимому, использует VoiceOver Recognition и применяет его к камере iPhone, чтобы предлагать описание мира почти в реальном времени. Эксперимент показывает, что может быть доступно пользователям iOS в ближайшие годы.

«Мы хотим продолжать создавать все больше и больше функций и заставлять эти функции работать вместе», — сказал Херрлингер. «Итак, какая бы комбинация ни была вам нужна для более эффективного использования вашего устройства, это наша цель».

Полностью интервью было загружено на YouTube, и его можно просмотреть ниже: