Вычислительная фотография Apple стремится к реализму

Полемика с телефонными камерами Samsung возобновила разговоры о компьютерной фотографии и высветила разницу между ней и подходом Apple к iOS.

Ни для кого не секрет, что Apple полагается на передовые алгоритмы и компьютерную фотографию почти во всех функциях камеры iPhone. Однако пользователи начинают задаваться вопросом, где провести грань между этими алгоритмами и чем-то более навязчивым, вроде изменения пикселей после захвата.

В этой статье мы рассмотрим полемику вокруг лунных фотографий Samsung, то, как компания занимается вычислительной фотографией, и что это означает для Apple и ее конкурентов в будущем.

Компьютерная фотография

Компьютерная фотография не является новой концепцией. Это стало необходимо, поскольку люди хотели большей производительности от своих крошечных камер смартфонов.

Основная идея заключается в том, что компьютеры могут выполнять миллиарды операций за мгновение, например, после нажатия затвора камеры, чтобы заменить базовые правки или применить более сложные исправления. Чем больше мы можем запрограммировать компьютер на действия после нажатия затвора, тем лучше может быть фотография.

Это началось с системы Apple с двумя камерами на iPhone 7. Другие инновации в области фотографии до этого, такие как Live Photos, можно было считать вычислительной фотографией, но портретный режим стал поворотным моментом для Apple.

В 2016 году Apple представила портретный режим, который использовал данные о глубине с двух камер iPhone 7 Plus для создания искусственного боке. Компания заявила, что это стало возможным благодаря системе с двумя камерами и усовершенствованному процессору сигналов изображения, который выполняет 100 миллиардов операций на фото.

Излишне говорить, что это было не идеально, но это был шаг в будущее фотографии. Технологии камер продолжат адаптироваться к форм-фактору смартфона, чипы станут быстрее, а датчики изображения станут мощнее на квадратный дюйм.

Портретный режим использует вычислительную фотографию для разделения переднего плана.

В 2023 году нет ничего необычного в том, чтобы снимать кинематографически размытое видео с использованием передовых вычислительных механизмов со смешанными результатами. Вычислительная фотография есть везде, от Photonic Engine до Photographic Styles — алгоритм обрабатывает каждую фотографию, сделанную на iPhone. Да хоть ProRAW.

Все это было вызвано желанием людей запечатлеть свою жизнь с помощью устройства, которое у них было под рукой — своего iPhone. У специализированных камер есть физика на их стороне с большими датчиками и гигантскими линзами, но средний человек не хочет тратить сотни или тысячи долларов на специальную установку.

Таким образом, вычислительная фотография расширила возможности крошечных сенсоров смартфонов. Усовершенствованные алгоритмы, основанные на больших базах данных, информируют процессор сигналов изображения о том, как получить идеальное изображение, обработать шум и экспонировать объект.

Однако существует большая разница между использованием вычислительной фотографии для расширения возможностей камеры и изменением изображения на основе данных, которые сенсор никогда не собирал.

Лунный выстрел Samsung

Для ясности: Apple использует модели машинного обучения — или «ИИ, искусственный интеллект» для тех, кто использует плохо придуманное популярное новое модное слово — для вычислительной фотографии. Алгоритмы предоставляют информацию об управлении захватом нескольких изображений для получения наилучших результатов или создания профилей глубины резкости.

Процессор изображений анализирует тон кожи, небо, растения, домашних животных и многое другое, чтобы обеспечить правильную цветопередачу и экспозицию, а не замену пикселей. Он не ищет объекты, такие как луна, для предоставления определенных улучшений на основе информации за пределами сенсора камеры.

Мы указываем на это, потому что те, кто обсуждает лунные фотографии Samsung, использовали вычислительную фотографию Apple в качестве примера того, как другие компании выполняют эти фотографические изменения. Это просто не так.

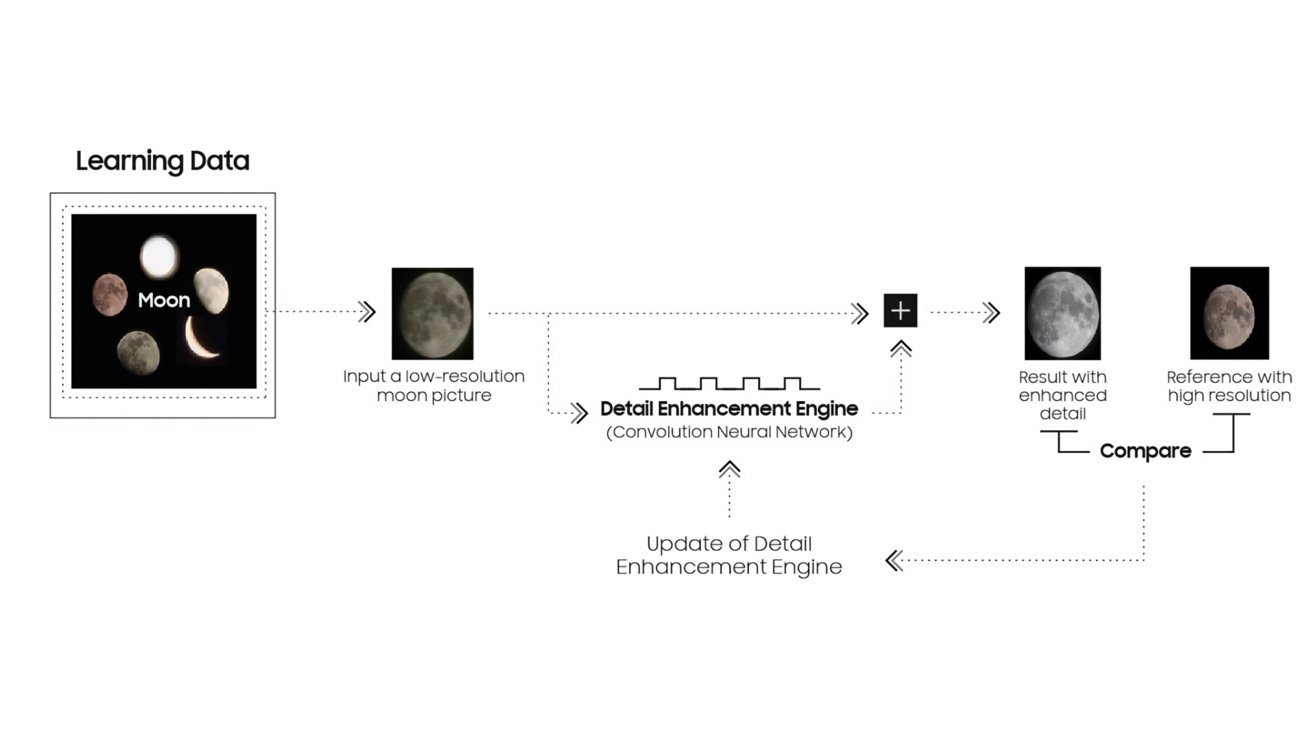

Лунный алгоритм Samsung в действии. Источник: u/ibreakphotos на Reddit

Компания Samsung задокументировала, как телефоны Samsung, начиная с Galaxy S10, обрабатывали изображения с помощью распознавания и изменения объектов. Оптимизатор сцены начал распознавать луну с Galaxy S21.

Как описано в недавно опубликованном документе, «ИИ» распознает луну на основе полученных данных, а функция механизма улучшения детализации применяется, чтобы сделать фотографию более четкой с помощью многокадрового синтеза и машинного обучения.

По сути, устройства Samsung распознают незатененную луну, а затем используют другие изображения высокого разрешения и данные о луне, чтобы синтезировать лучший результат. В результате получается не изображение, снятое камерой устройства, а нечто новое и сфабрикованное.

В целом, эта система умна, потому что Луна выглядит одинаково независимо от того, где на нее смотреть на Земле. Меняется только цвет света, отраженного от его поверхности, и фаза самой луны. Усиление луны на фотографии всегда будет простым расчетом.

Устройства Samsung и Apple используют экспозицию нескольких фотографий для расширенных вычислений. Оба анализируют несколько захваченных изображений для наилучшей части каждого и объединяют их в одно превосходное изображение. Тем не менее, Samsung добавляет дополнительный шаг для распознанных объектов, таких как луна, который вводит новые данные из других изображений луны с высоким разрешением, чтобы исправить луну в окончательном захваченном изображении.

Объяснение лунного алгоритма Samsung. 1 кредит

Это не обязательно плохо. Это просто не то, что Samsung не разъяснила в своей рекламе или маркетинге продукта, что может привести к путанице у клиентов.

Проблема с этим процессом и причина, по которой ведутся дебаты, заключается в том, как это влияет на будущее фотографии.

Короче говоря, окончательное изображение не отражает того, что обнаружил датчик и обработал алгоритм. Он представляет собой идеализированную версию того, что могло бы быть, но не так, потому что сенсор камеры и объектив слишком малы.

Грядущая битва за реализм

С нашей точки зрения, ключевым принципом фотографии на iPhone всегда был реализм и точность. Если есть идеальная середина по насыщенности, резкости и экспозиции, Apple за последнее десятилетие приблизилась к центру, даже если она не всегда оставалась идеально стабильной.

Мы признаем, что фотография невероятно субъективна, но кажется, что фотография Android, а именно Samsung, отошла от реализма. Опять же, не обязательно негативный, но самоуверенный выбор, сделанный Samsung, с которым приходится сталкиваться покупателям.

Что касается этого обсуждения, устройства Samsung и Pixel постепенно отклоняются от этого идеального реалистичного репрезентативного центра. Они борются за большую насыщенность, резкость или дневную экспозицию ночью.

В приведенном выше примере показано, как Galaxy S22 Ultra предпочитал большую экспозицию и насыщенность, что приводило к потере деталей. Невинный и самоуверенный выбор, но в этом случае iPhone 13 Pro отправляется домой с более подробной фотографией, которую можно отредактировать позже.

Эта разница в том, как снимаются фотографии, устанавливается в самоуверенных алгоритмах, используемых каждым устройством. По мере развития этих алгоритмов будущие решения в области фотографии могут привести к более взвешенному выбору, который нельзя будет отменить позже.

Например, изменяя внешний вид луны с помощью передовых алгоритмов без предупреждения пользователя, это изображение навсегда изменяется, чтобы соответствовать тому, что Samsung считает идеальным. Конечно, если пользователи знают, как отключить эту функцию, они могут это сделать, но, скорее всего, этого не сделают.

Мы воодушевлены будущим фотографии, но, как энтузиасты фотографии, надеемся, что оно не такое уж невидимое. Подобно портретному режиму Apple, Live Photos и другим методам обработки — включите их с помощью очевидных переключателей. Также сделайте его обратимым.

Нажатие затвора в приложении основной камеры устройства должно сделать репрезентативную фотографию того, что видит датчик. Если пользователь хочет большего, позвольте ему добавить его с помощью переключателей до или после редактирования.

А пока попробуйте сфотографировать ночное небо, используя только iPhone и штатив. Оно работает.

Почему это важно

Важно подчеркнуть, что нет никаких проблем с заменой уродливого светящегося шара в небе на настоящую луну, а также нет проблем с удалением людей или мусора (или людей из мусора) с фотографии. Однако он должен быть контролируемым, переключаемым и видимым для пользователя процессом.

Вычислительная фотография — это будущее, к лучшему или к худшему

По мере развития алгоритмов мы будем видеть все больше идеализированных и обработанных изображений со смартфонов Android. Худшие нарушители сразу удалят или заменят объекты без предварительного уведомления.

Apple неизбежно улучшит обработку изображений и алгоритмы на своих устройствах. Но, основываясь на том, как компания до сих пор подходила к фотографии, мы ожидаем, что она будет делать это с учетом стремления пользователя к реализму.

Трайбализм в техническом сообществе всегда вызывал споры среди пользователей. К ним относятся Mac или ПК, iPhone или Android, а вскоре и реальные или идеальные фотографии.

Мы надеемся, что в будущем Apple продолжит выбирать реализм и пользовательский контроль над фотографиями. Предоставление компании полного контроля над тем, что пользователь снимает на камеру, вплоть до изменения изображений в соответствии с идеалом, не похоже на будущее, частью которого мы хотим быть.