Хорек в дикой природе [Pixabay/Michael Sehlmeyer]

Ferret LLM от Apple может помочь Siri понять расположение приложений на дисплее iPhone, потенциально расширяя возможности цифрового помощника Apple.

Apple работает над многочисленными проектами машинного обучения и искусственного интеллекта, которые она могла бы представить на WWDC 2024. В только что опубликованном документе теперь кажется, что некоторые из этих работ могут помочь Siri понять, как выглядят приложения и сама iOS.

Статья, выпущенная Корнеллским университетом в понедельник, называется «Ferret-UI: обоснованное понимание мобильного пользовательского интерфейса с помощью мультимодальных программ магистратуры». По сути, это объясняет новую мультимодальную модель большого языка (MLLM), которая потенциально способна понимать пользовательские интерфейсы мобильных дисплеев.

Название Ferret изначально появилось в результате мультимодальной программы LLM с открытым исходным кодом, выпущенной в октябре исследователями из Корнельского университета, работающими с коллегами из Apple. В то время Феррет мог обнаруживать и понимать различные области изображения для выполнения сложных запросов, например, для определения вида животного в выбранной части фотографии.

Развитие LLM

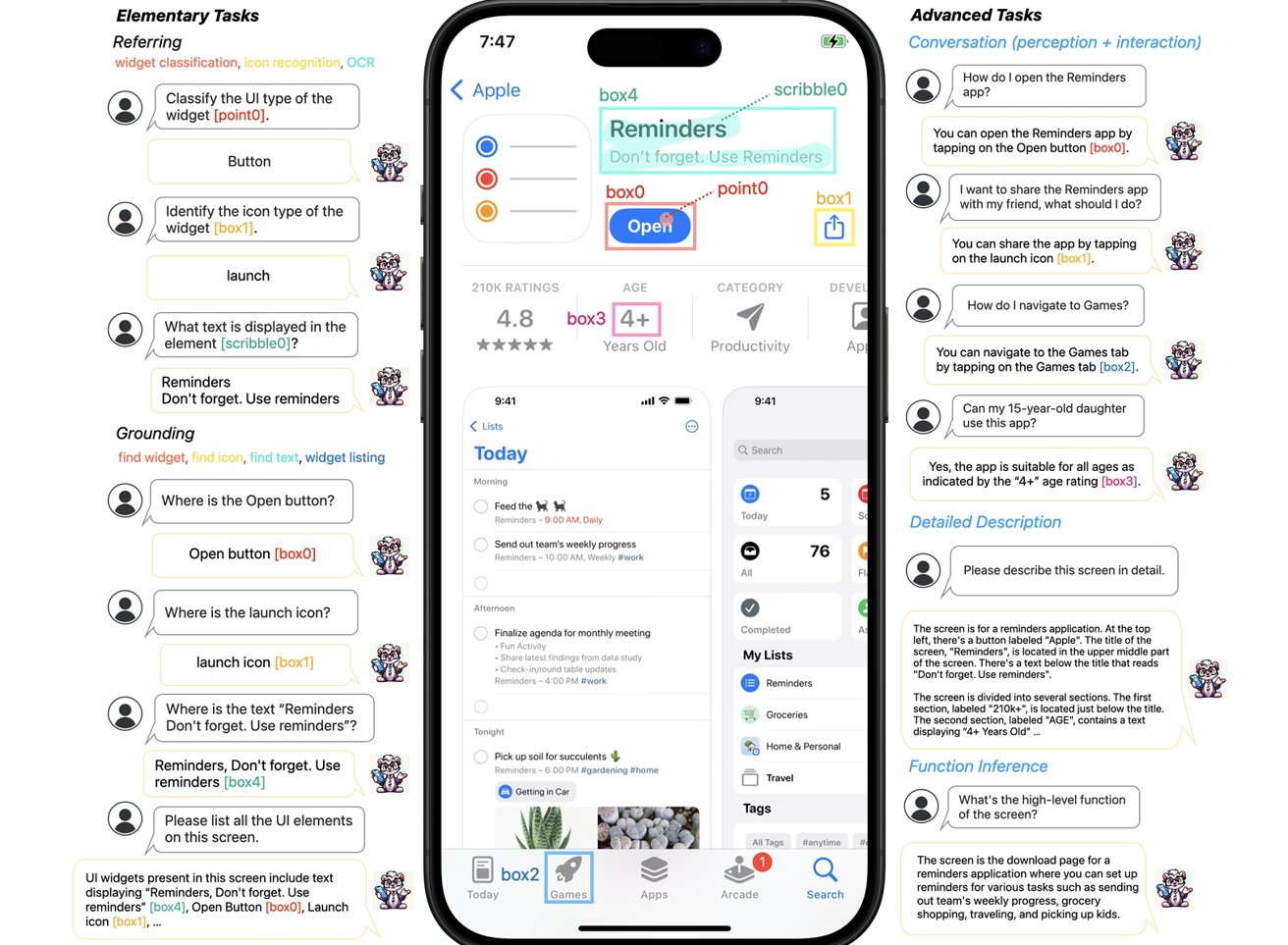

В новой статье Ferret-UI объясняется, что, хотя в использовании MLLM и наблюдаются заметные успехи, им все еще «не хватает способности понимать и эффективно взаимодействовать с экранами пользовательского интерфейса (UI)». Ferret-UI описывается как новый MLLM, предназначенный для понимания экранов мобильного пользовательского интерфейса и оснащенный «возможностями обращения, обоснования и рассуждения».

Часть проблемы, с которой сталкиваются LLM при понимании интерфейса мобильного дисплея, заключается в том, как он вообще используется. Часто в портретной ориентации это означает, что значки и другие детали могут занимать очень компактную часть дисплея, что затрудняет понимание машинами.

Чтобы помочь в этом, у Ferret есть система увеличения, позволяющая масштабировать изображения до «любого разрешения», чтобы сделать значки и текст более читабельными.

Пример Ferret-UI, анализирующего дисплей iPhone

Для обработки и обучения Феррет также делит экран на две меньшие части, разрезая экран пополам. В документе говорится, что другие LLM, как правило, сканируют глобальное изображение с более низким разрешением, что снижает способность адекватно определять, как выглядят значки.

Добавление значительного количества данных для обучения привело к созданию модели, которая может в достаточной степени понимать запросы пользователей, понимать природу различных элементов на экране и предлагать контекстуальные ответы.

Например, пользователь может спросить, как открыть приложение «Напоминания», и ему будет предложено нажать кнопку «Открыть» на экране. Следующий запрос о том, может ли 15-летний подросток использовать приложение, может проверить возрастные рекомендации, если они видны на дисплее.

Вспомогательный помощник

Хотя мы не знаем, будет ли он интегрирован в такие системы, как Siri, Ferret-UI предлагает возможность расширенного контроля над таким устройством, как iPhone. Понимая элементы пользовательского интерфейса, он дает возможность Siri выполнять действия для пользователей в приложениях, самостоятельно выбирая графические элементы внутри приложения.

Также есть полезные приложения для слабовидящих. Такой LLM мог бы быть более способен подробно объяснить, что происходит на экране, и потенциально выполнять действия для пользователя без необходимости делать что-либо еще, кроме как попросить, чтобы это произошло.