Делитесь содержимым, найденным на экране, в приложениях с помощью Apple Intelligence благодаря новым API.

Вскоре Siri сможет просматривать и обрабатывать контент на экране благодаря новым API-интерфейсам для разработчиков, основанным на технологиях, опубликованных до WWDC.

В понедельник Apple выпустила новую документацию, которая поможет разработчикам подготовиться к появлению новых функций Siri и Apple Intelligence. Последний API-интерфейс компании для разработчиков показывает, что Siri получит значительную контекстуальную осведомленность и что в какой-то момент виртуальный помощник сможет использовать информацию из контента, отображаемого в данный момент на экране.

Siri, несомненно, станет намного полезнее благодаря изменениям Apple. Компания предоставила список примеров, которые дают некоторое представление о том, что именно новая и улучшенная Siri с искусственным интеллектом сможет делать в будущем.

Пользователи смогут задавать Siri вопросы о веб-странице, которую они сейчас просматривают, или о конкретном объекте на фотографии. Виртуальный помощник также сможет суммировать документы и электронные письма по запросу или дополнять тексты, добавляя дополнительный контент.

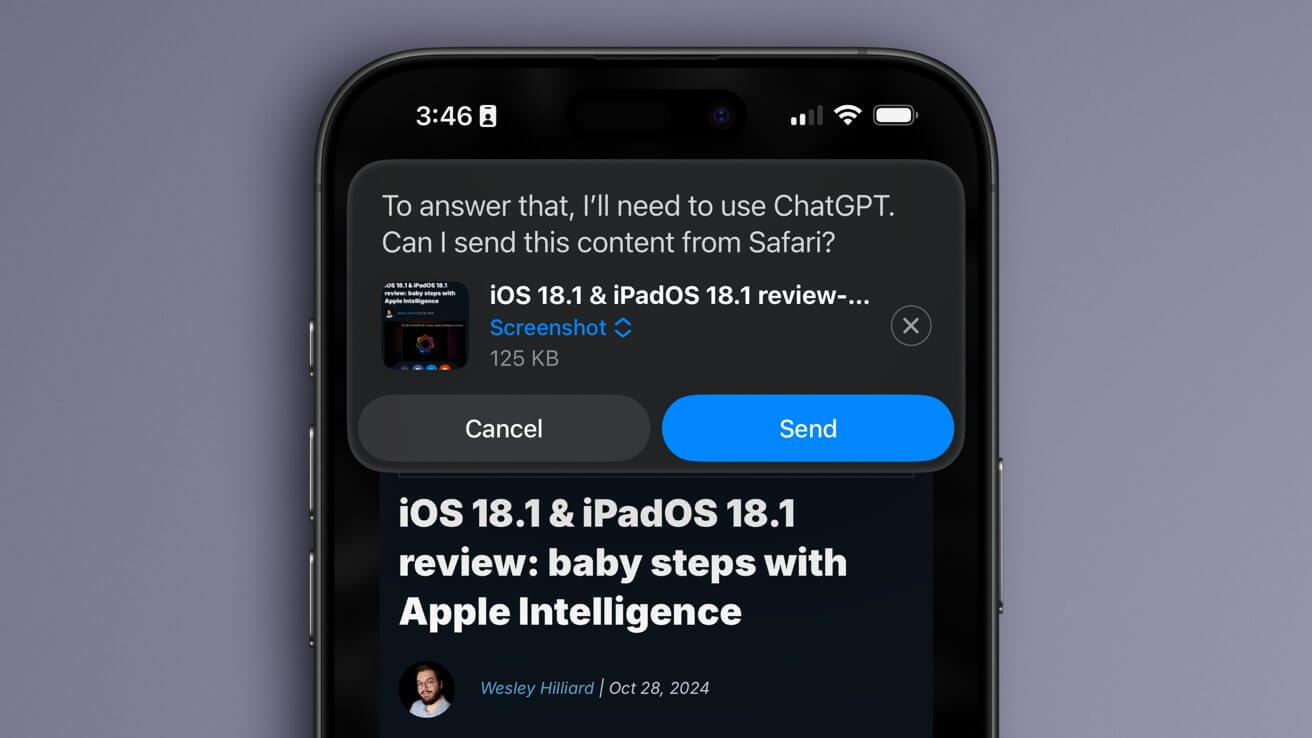

Обратите внимание, что некоторые из этих функций уже стали возможными в первой бета-версии iOS 18.2 для разработчиков, в которой была реализована интеграция ChatGPT. Siri может пересылать PDF-файл, текстовый документ или изображение в ChatGPT для определенных действий, но только с разрешения пользователя.

Новый API для разработчиков указывает на то, что Apple хочет еще больше упростить этот процесс. Вместо того, чтобы пользователь просил Siri отправить документ в ChatGPT, он сможет задавать прямые вопросы о странице на экране или каким-либо образом использовать информацию с нее. Здесь есть много возможностей для улучшения, поскольку ChatGPT в настоящее время может получать доступ только к снимкам экрана или документам, предоставленным пользователем вручную.

Siri может вскоре получить возможность использовать экранный контент.

Идея Apple о том, чтобы ИИ использовал экранную информацию, была очевидна еще до того, как Apple Intelligence была анонсирована на WWDC. Опубликованные исследования компании, в частности, касающиеся модели Ferret, послужили индикатором планов Apple в области искусственного интеллекта.

Большое значение уделялось анализу документов, их пониманию и генерации текста с помощью искусственного интеллекта. В одном из наших недавних отчетов описал различные приложения для внутреннего тестирования, которые использовались, когда Apple Intelligence все еще находилась в разработке.

Тестовые приложения и среды, в частности приложение 1UP, отражают многие функции, которые в настоящее время возможны благодаря интеграции ChatGPT в бета-версии iOS 18.2. У Apple также было специальное приложение для тестирования умных ответов в почте и сообщениях.

Новая способность Siri заполнять и обобщать тексты или отвечать на вопросы об изображениях, документах и веб-страницах также была раскрыта перед официальным анонсом. В наших отчетах об Ajax LLM, а также о проектах BlackPearl и Greymatter мы раскрыли многие из этих функций, объяснили, как они будут работать, и даже перефразировали подсказки Apple по искусственному интеллекту.

Очевидно, что производитель iPhone весьма серьезно относится к искусственному интеллекту, учитывая количество времени, исследований и усилий, затраченных на его проекты по генеративному искусственному интеллекту. API для разработчиков в понедельник был выпущен только для того, чтобы помочь разработчикам подготовиться к новым функциям Siri, которые, по слухам, дебютируют в 2025 году с обновлением iOS 18.4.