Apple продолжает вносить ясность в отношении функции обнаружения CSAM (материалов сексуального насилия над детьми), о которой она объявила на прошлой неделе. В дополнение к подробному документу с часто задаваемыми вопросами, опубликованному ранее сегодня, Apple также подтвердила, что обнаружение CSAM применяется только к фотографиям, хранящимся в iCloud Photos, а не к видео.

Компания также продолжает защищать свою реализацию обнаружения CSAM как более дружественную и обеспечивающую конфиденциальность, чем другие компании.

Apple подтвердила сегодня, что при запуске обнаружение CSAM будет применяться только к фотографиям, хранящимся в iCloud Photos, а не к видео. Однако, учитывая распространение видео в контенте CSAM, компания признала, что в будущем она может сделать еще больше, и со временем она может расширять и развивать свои планы.

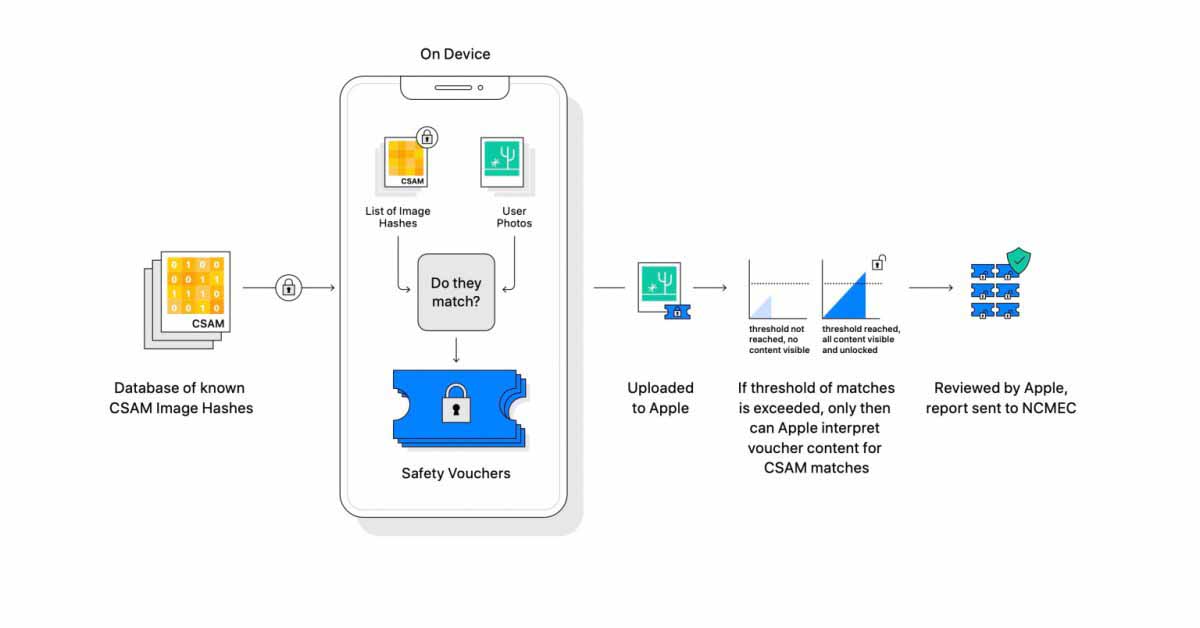

Это имеет смысл, если вы сделаете шаг назад и посмотрите, как работает сканирование Apple на предмет обнаружения CSAM. Все сопоставления производятся на устройстве, при этом Apple преобразует базу данных фотографий из Национального центра пропавших без вести и эксплуатируемых детей в «нечитаемый набор хэшей, который надежно хранится на устройствах пользователей». Затем база данных на устройстве сравнивается с фотографиями, и на устройстве обнаруживается совпадение, затем устройство создает ваучер криптографической безопасности, который кодирует результат совпадения.

Apple также подчеркивает, что, если пользователь не использует Фото iCloud, никакая часть процесса обнаружения CSAM не запускается. Это означает, что если пользователь хочет отказаться от процесса обнаружения CSAM, он может отключить iCloud Photos.

Наконец, Apple также вдвойне подчеркивает, почему она считает, что ее реализация обнаружения CSAM на устройстве намного лучше, чем реализации на стороне сервера, используемые другими компаниями. Эти реализации, как объясняет Apple, требуют, чтобы компания сканировала каждую фотографию, сохраненную пользователем на ее сервере, большинство из которых не являются CSAM.

Реализация Apple обнаружения CSAM не требует, чтобы серверы Apple сканировали каждую фотографию. Перенос процесса на устройство делает метод Apple более безопасным и предназначен только для проверки хэшей изображений по базе данных NCMEC изображений известного CSAM, в отличие от сканирования всех изображений на стороне сервера.

![Satechi выпускает тонкую механическую клавиатуру и анонсирует складные зарядные устройства Qi2 для нескольких устройств [U]](https://applepro.news/wp-content/uploads/2024/04/1714073720_satechi-vypuskaet-tonkuyu-mehanicheskuyu-klaviaturu-i-anonsiruet-skladnye-zaryadnye-ustrojstva-100x100.jpg)