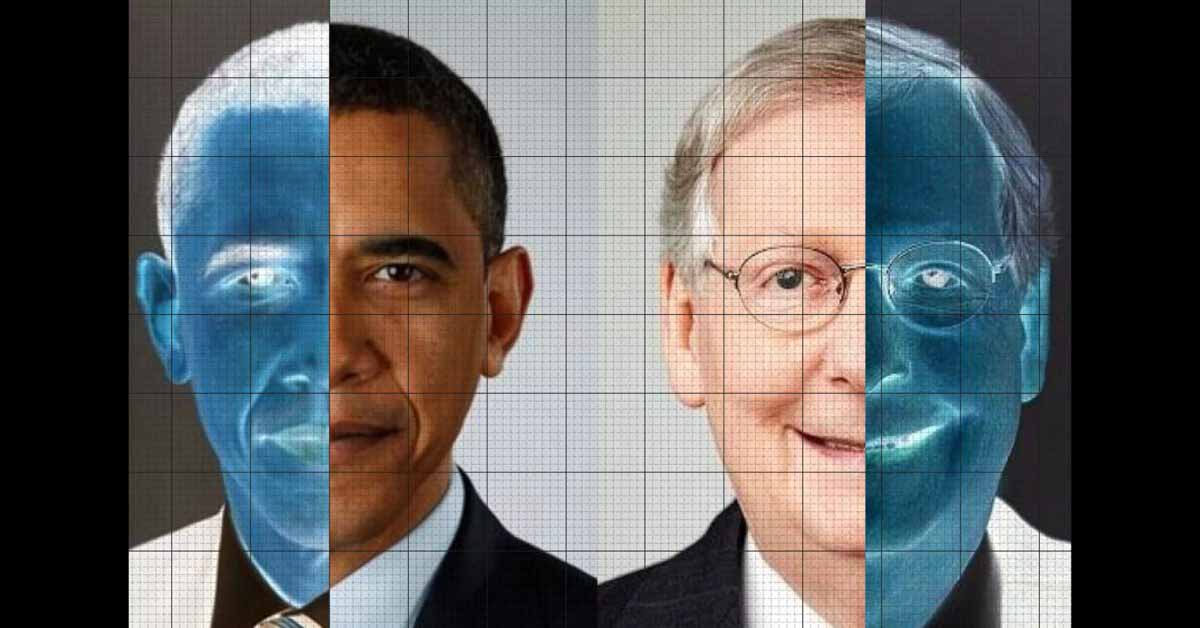

Функция обрезки фотографий в Twitter, которая использует машинное обучение, чтобы решить, какую часть фотографии показывать в каналах пользователей, была обвинена в расизме и сексизме в прошлом году, когда было обнаружено, что она с большей вероятностью вырезает чернокожих людей и женщин.

Компания объявила награду за обнаружение ошибок для всех, кто сможет доказать предвзятость в ее алгоритмах, и теперь назвала победителей, которые различными способами доказали ряд предубеждений …

Задний план

Когда вы загружаете в Twitter фотографию с портретной ориентацией, система автоматически обрезает ее для отображения горизонтальной версии в лентах пользователей. Полная версия отображается только тогда, когда люди нажимают на нее или нажимают на нее.

Пользователи Twitter начали замечать, что если на фотографии были изображены люди с разным цветом кожи или разного пола, то на кадре с большей вероятностью был изображен белый мужчина, чем темнокожая женщина.

В ответ компания показала менее обрезанные версии, но также объявила о внутреннем расследовании и внешнем конкурсе, чтобы доказать предвзятость своих алгоритмов. Он объявил результаты конкурса.

Результаты конкурса по кадрированию фотографий в Twitter

Учетная запись Twitter Engineering твитнул результаты, и ссылка на видео с презентациями (ниже).

1-е место занимает @hiddenmarkov, чья работа продемонстрировала, как применение фильтров красоты может изменить внутреннюю скоринговую модель алгоритма. Это показывает, как алгоритмические модели усиливают предубеждения в реальном мире и социальные ожидания красоты.

2-е место занимает @halt_ai, который обнаружил, что алгоритм заметности увековечивает маргинализацию. Например, изображения пожилых людей и инвалидов подверглись дальнейшей маргинализации за счет их вырезания из фотографий и усиления пространственного искажения взгляда.

3-е место занимает @RoyaPak, который экспериментировал с алгоритмом заметности Twitter, используя двуязычные мемы. В этой записи показано, как алгоритм предпочитает обрезку латинских шрифтов арабским шрифтам и что это означает с точки зрения вреда для языкового разнообразия в Интернете.

Самую инновационную награду в награде за алгоритмическую предвзятость получает @OxNaN, который исследовал общение на основе эмодзи, чтобы выявить предвзятость в алгоритме, который отдает предпочтение эмодзи светлого тона кожи. Эта запись показывает, как благонамеренные корректировки фотографий могут привести к изменению яркости изображения.

Полные результаты подтвердили расизм, сексизм, эйджизм, эйлизм и многое другое. Один участник даже обнаружил, что алгоритм предпочитает смайлики с более светлым оттенком кожи смайликам с более темным оттенком кожи!

Твиттер ссылается на код для каждой победившей записи на Github.

Теперь перед Твиттером стоит задача исправить эти предубеждения, что может оказаться более сложной задачей, чем доказательство их существования.

Изображение: Отчет кассира