Apple работает над внедрением искусственного интеллекта в Siri

Исследование Apple AI выявило модель, которая сделает подачу команд Siri быстрее и эффективнее за счет преобразования любого заданного контекста в текст, который легче анализировать с помощью модели большого языка.

Исследования искусственного интеллекта в Apple продолжают публиковаться по мере того, как компания приближается к публичному запуску своих инициатив в области искусственного интеллекта в июне во время WWDC. На данный момент опубликовано множество исследований, в том числе инструмент для анимации изображений.

Последней статьей впервые поделился VentureBeat. В документе подробно описано так называемое ReALM — эталонное разрешение как языковое моделирование.

Когда компьютерная программа выполняет задачу, основанную на расплывчатых языковых входных данных, например, на том, как пользователь может сказать «то» или «то», это называется эталонным разрешением. Это сложная проблема, которую нужно решить, поскольку компьютеры не могут интерпретировать изображения так, как это делают люди, но Apple, возможно, нашла упрощенное решение с помощью LLM.

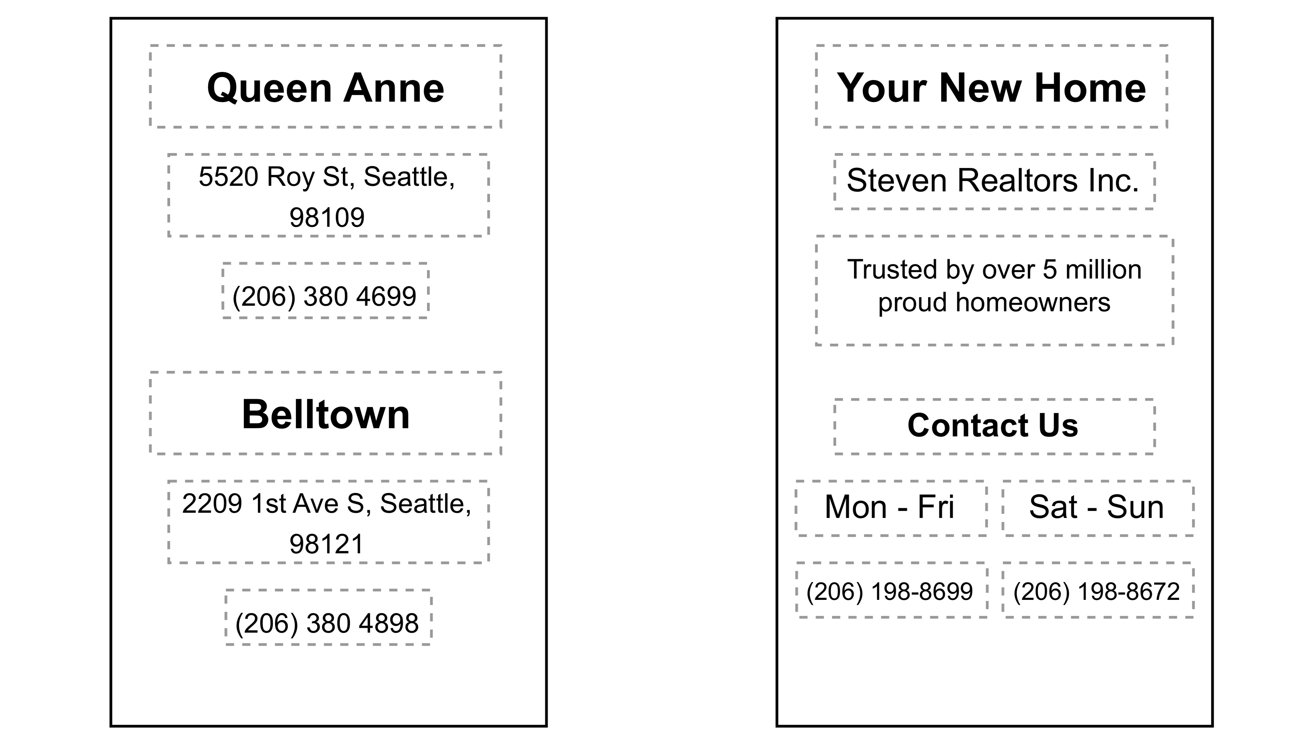

Разговаривая с умными помощниками, такими как Siri, пользователи могут ссылаться на любое количество контекстной информации для взаимодействия, например, фоновые задачи, данные на дисплее и другие неразговорные объекты. Традиционные методы анализа основаны на невероятно больших моделях и справочных материалах, таких как изображения, но Apple упростила подход, преобразовав все в текст.

Apple обнаружила, что ее самые маленькие модели ReALM работают аналогично GPT-4 с гораздо меньшим количеством параметров и поэтому лучше подходят для использования на устройстве. Увеличение параметров, используемых в ReALM, позволило ему существенно превзойти GPT-4.

Одной из причин такого повышения производительности является использование GPT-4 анализа изображений для понимания информации на экране. Большая часть данных обучения изображений построена на естественных изображениях, а не на веб-страницах с искусственным кодом, заполненных текстом, поэтому прямое распознавание текста менее эффективно.

Представление данных снимка экрана в виде текста. Источник: исследование Apple.

Преобразование изображения в текст позволяет ReALM пропустить необходимость в этих расширенных параметрах распознавания изображений, что делает его меньше и эффективнее. Apple также позволяет избежать проблем с галлюцинациями, включая возможность ограничить декодирование или использовать простую постобработку.

Например, если вы прокручиваете веб-сайт и решаете, что хотите позвонить в компанию, просто сказав «позвонить в компанию», Siri потребует от Siri проанализировать то, что вы имеете в виду, с учетом контекста. Он сможет «увидеть», что на странице есть номер телефона, помеченный как рабочий номер, и позвонить по нему без дальнейшего запроса пользователя.

Apple работает над выпуском комплексной стратегии искусственного интеллекта во время WWDC 2024. Некоторые слухи предполагают, что компания будет полагаться на меньшие модели на устройствах, которые сохраняют конфиденциальность и безопасность, одновременно лицензируя LLM других компаний для более спорной обработки вне устройства, наполненной этическими загадками.